Co to jest Big Tech? Jest to jedno z ogólnych określeń Internetu wielkich korporacji, ich produktów i usług lub nich samych. Czasami korzystając z technologii czujemy, że coś jest na nas wymuszane, a tych którzy nie zaakceptują zaistniałego stanu rzeczy czekają srogie konsekwencje – wykluczenie z życia społecznego, izolacja. Dlatego będąc istotami społecznymi, godzimy się na pewne niedogodności – ot, choćby korzystanie ze środków komunikacji, które nie do końca nam odpowiadają, może np. wyświetlają nam reklamy, rozładowują i spowalniają telefon, lub zajmują zbyt dużo miejsca.

Czasem są to groźniejsze problemy, jak algorytmy rekomendacyjne żerujące na naszych emocjach, słabościach i lękach lub powodujące uzależnienie. Czasem opłaty za coś, co nic nie kosztuje (np. odblokowanie ciemnego motywu, usunięcie reklam, etc.), wymuszone aktualizacje, nieuzasadniony wymóg logowania, posiadania stałej łączności z Internetem czy nawet podawania numeru telefonu. Lub wycofanie usługi z której korzystaliśmy, usunięcie ulubionej książki, serialu.

Niektóre trudności pojawiają się na naszej drodze dopiero gdy poczujemy potrzebę odzyskania kontroli i łapiemy za kierownicę: dyskryminacja przeglądarkowa, dark patterny, blokady regionalne, utrudniona migracja do innej usługi czy szeroko pojęta niekompatybilność ze światem. Całe mnóstwo złośliwości. Nawet nasze własne urządzenia zaczęły odmawiać nam posłuszeństwa. Jak to się stało, że staliśmy się chłopami na nie-swojej ziemi? Co robić, jak żyć?

Co to dyskryminacja przeglądarkowa?

Mamy z nią do czynienia, gdy strona mówi „twoja przeglądarka nie jest obsługiwana” i odmawia współpracy, choć używana przeglądarka ma w sobie wszystko co trzeba. Strony robią to, aby zmusić użytkowników do używania przeglądarek, które są gorzej zabezpieczone przed śledzeniem.

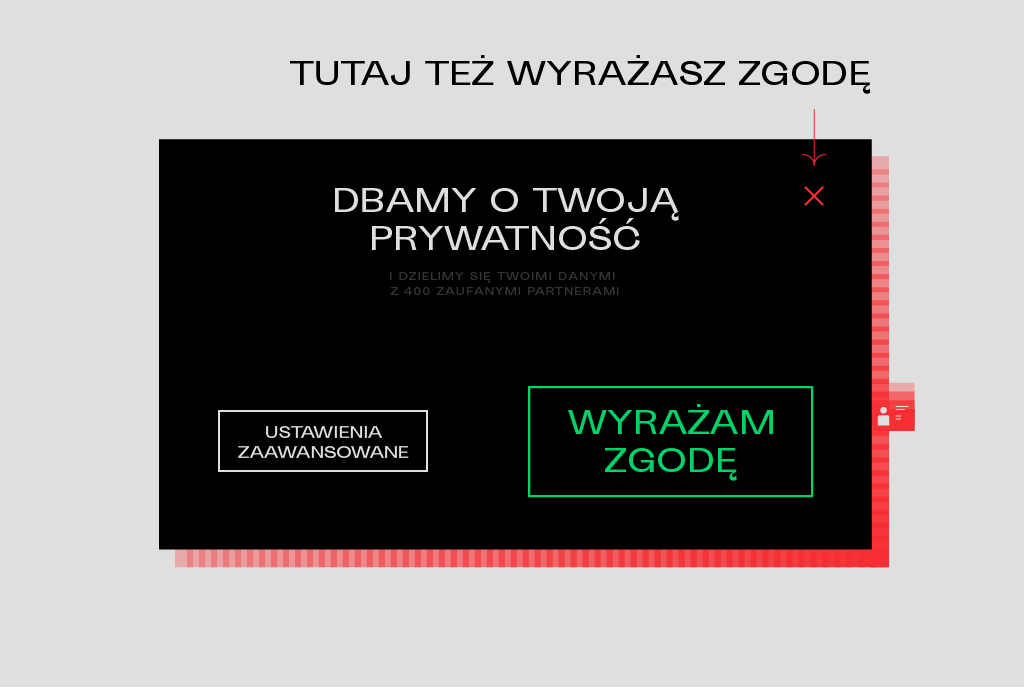

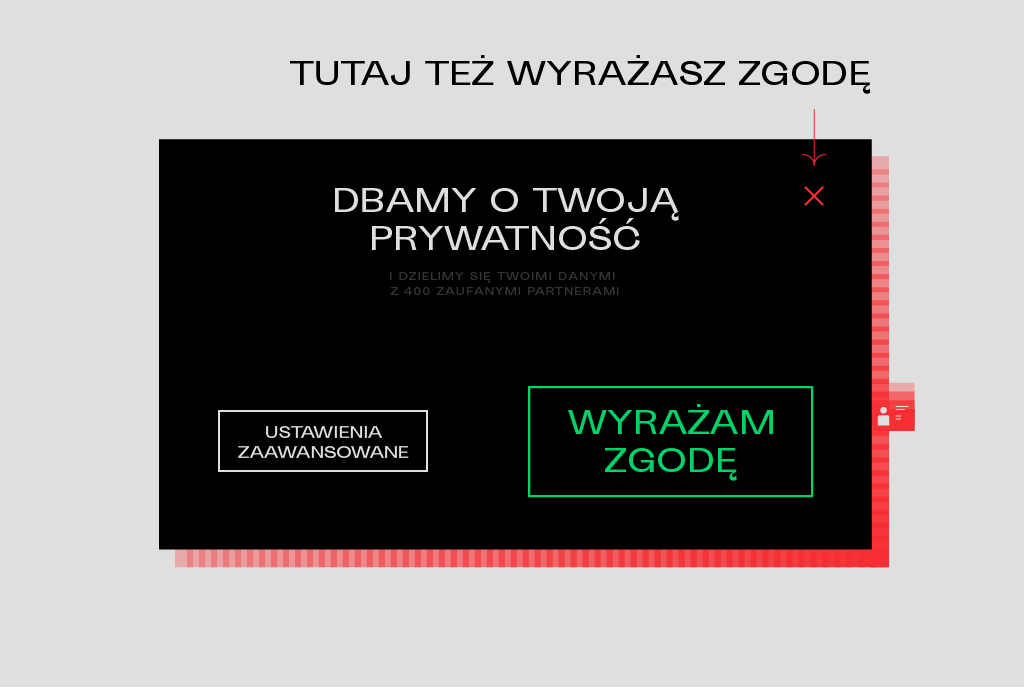

Co to dark patterny?

Manipulacyjne interfejsy, zaprojektowane aby użytkownik zrobił coś innego niż chciał. Najczęstszym przykładem są pop-upy o cookiesach śledzeniu z najważniejszymi informacjami zapisanymi drobnym druczkiem, rozwleczoną polityką prywatności, aby nikomu nie chciało się jej czytać, w których zgodę można wyrazić jednym kliknięciem w wyróżniony przycisk, a sprzeciw wymaga wejścia w opcje zaawansowane i szukania switchy do odznaczenia.

Przykłady dark patternów

Co to blokady regionalne?

Ograniczenia, w jakim kraju można oglądać film. Weryfikacja odbywa się na podstawie adresu IP, który ujawnia przybliżoną lokalizację. Jeśli ktoś korzysta z proxy, VPN-a lub TOR-a, strona widzi inny adres IP i jeśli się zorientuje – może to uznać za próbę ominięcia blokady. Równie dobrze prawdziwym powodem może być ochrona metadanych przed dostawcą Internetu. Jeśli tymczasowo przebywasz za granicą – również możesz doświadczyć blokad regionalnych.

Ktoś kiedyś powiedział, że „jeśli nie podobają mi się warunki, zawsze mogę odejść. Wyprowadzić się w Bieszczady, uciec od cywilizacji i żyć w zgodzie z naturą”. Ironiczny komentarz sugerujący, jakoby to wszystko było nierozerwalnie związane z postępem cywilizacyjnym i stanowiło warunek egzystowania we współczesnym świecie, a przeciwstawianie się temu to jak walka z wiatrakami. Zwykły szary człowiek nic sam nie zdziała.

...ale czy na pewno? Czyżbyśmy naprawdę byli całkowicie bezsilni, zdani na łaskę i niełaskę Big Techu? Śmiem twierdzić, iż jest zgoła inaczej. Wiele możemy nawet jako indywidualne jednostki, a jako społeczeństwo – jeszcze więcej. Nawet jeśli uzyskana w ten sposób wolność cyfrowa nie będzie zupełna, moim skromnym zdaniem, lepiej mieć jej trochę, na tyle na ile to możliwe, niż poddać się już na starcie, nie spróbowawszy czy da się.

Jak kiedyś wspomniałem, alternatywny internet (outernet, small net) jawnie sprzeciwia się Big Techowi. Razem stworzyliśmy alternatywny ekosystem technologii (nie ograniczając się do samych tylko aplikacji). Tworzone przez nas rozwiązania istnieją aby rozwiązywać problemy – nie pomnażać kapitał. Toteż korzystanie z tych rozwiązań zapewnia inne doświadczenie, w którym nasze prawa są respektowane, a wręcz stawiane na pierwszym miejscu, wszak działamy dla wspólnego interesu.

Nasz główny problem dotyczy marginalnej siły przebicia do mainstreamu. Tak już jest, że najpopularniejsze rozwiązania rzadko bywają tymi dobrymi. Jeśli chcesz wolności, nie musisz wyjeżdżać w Bieszczady. Będziesz musiał jednak wymienić prawie wszystkie swoje aplikacje i serwisy internetowe z których korzystasz na alternatywy. Może się to wydawać przerażające, ale na szczęście nie musisz zmieniać wszystkiego naraz. Zmień jedną rzecz i systematycznie się jej trzymaj, a gdy się przyzwyczaisz – następną.

Przedstawiam kilka kroków, od których możesz zacząć swoją migrację z Big Techu.

Pierwszy krok jest trywialny – zmiana dotyczy jedynie używanych sformułowań. Powstrzymaj się od robienia reklamy. W swojej mowie zastępuj nazwy firm i ich produktów ogólnymi wyrażeniami, o ile oczywiście nie jest to kluczowe dla informacji jaką chcemy przekazać.

Przykłady:

- wygoogluj → wyszukaj

- Excel → arkusz kalkulacyjny

- Photoshop → edytor grafiki

- oglądamy Netflixa → oglądamy seriale

- na Instagramie → w Internecie (*Instagram ≠ Internet!)

Inni nie muszą wiedzieć, że to właśnie WhatsAppem ktoś wysłał ci śmieszny filmik. Z zasady tej możesz wyłączyć Wikipedię – to dobry i pożyteczny serwis i warto go promować.

Krok 2 – zmień domyślną wyszukiwarkę

Frazy które wpisujemy w wyszukiwarkę to jedne z najwięcej mogących o nas zdradzić danych. Są wśród nich takie rzeczy, których byśmy nikomu nie powiedzieli. To również najcenniejsze informacje dla reklamodawców. Jeśli korzystasz z wyszukiwarki Google, powinieneś to zmienić, ponieważ może łatwo powiązać wyszukiwania z twoją tożsamością, co wynika z pośrednictwa w znacznej ilości twoich interakcji internetowych (często nawet nie zdajesz sobie z tego sprawy) i swoim zasięgiem obejmuje znaczną część twojej cyfrowej przestrzeni. Nawet jeśli obecnie nie odczuwasz potrzeby ochrony prywatności, twoje zaufanie do instytucji może w przyszłości ulec zmianie, a danych, które raz trafiły w obieg, już nie wycofasz.

Po co mi prywatność?

W prywatności chodzi o kontrolę nad tym, z kim dzielimy się jakimi informacjami. Nie każda informacja jest przeznaczona dla każdego – jednymi chcemy się podzielić tylko z bliskimi, inne zachować dla siebie. Prywatność jest jednym z praw człowieka, choć przez niektórych bywa kryminalizowana w imię walki z przestępczością. Takim osobom rekomenduję interaktywną lekturę pt. Social Cooling i może utrzymany w satyrycznym tonie komentarz Oliwiera Jaszczyszyna (o ile go nie usunął).

Jeszcze do niedawna powiedziałbym „użyj DuckDuckGo”, jednak obecnie mam spore obiekcje co do faktycznego poziomu prywatności, jaką rzekomo zapewnia. Nie polecam, chyba że miałbym wybierać między nim a Google.

Oto kilka alternatyw:

- StartPage zaciąga wyniki od Google, ale w sposób anonimowy

- Mojeek z własnym, niezależnym indeksem wyszukiwania

- Wyszukiwarka Brave

A może coś z polskiego podwórka – SVMetaSearch? To tzw. metawyszukiwarka, która zaciąga wyniki z wielu innych wyszukiwarek jednocześnie, pozwalając wybrać źródła. Buduje również swój własny mini-indeks.

Wybierz to, co najlepiej odpowiada twoim potrzebom i trzymaj się z dala od Google.

Krok 3 – zainstaluj wtyczkę blokującą reklamy

Blokowaniu reklam poświęciłem cały wpis, skupiając się na przedstawieniu wtyczki zwanej „uBlock Origin”. Reklamy potrafią być irytujące, marnują nasz czas i wydłużają ładowanie stron. To zarazem jedna z rzeczy powszechnie akceptowanych w korporacyjnym Internecie, bez wyrazu sprzeciwu. Przy tym generują ogromną ilość śladu węglowego, zanieczyszczając naszą planetę, a nas pozbawiają prywatności.

Nie daj sobie wmówić, że ingerencja w działanie czyjejś strony w twojej przeglądarce jest czymś złym. Że twórca ma prawo zmusić cię do oglądania reklam. Przeglądarka jest twoja i masz prawo skonfigurować ją tak, jak tobie się to podoba, tak samo jak masz prawo wyprosić obcego ze swojego domu. Instalując bloker reklam, stawiasz na swoim, mówisz „w mojej przestrzeni cyfrowej rządzę ja”.

To pierwszy krok, w którym twoje dotychczasowe doświadczenia z Internetem zaczną się poprawiać. Do tej pory byłeś bombardowany krzykliwymi banerami starającymi się przyciągnąć twoją uwagę, wyskakującymi okienkami, powiadomieniami i autoodtwarzającym się wideo. Teraz (zwłaszcza gdy włączysz wszystkie filtry w UBO) znikną wszystkie rozpraszacze i zostaniesz z niemalże samą treścią. Początkowo może to wywołać lekki szok, ale niewątpliwie pozytywny.

Dodatkowo UBO ostrzega przed niektórymi stronami rozpowszechniającymi zainfekowane oprogramowanie. I – uwaga – można go zainstalować na urządzeniach mobilnych! (dzięki przeglądarce Firefox)

Jednocześnie, na tym etapie niektórzy będą starali się ciebie zawrócić, powiedzieć „zaraz zaraz, gości z adblockami nie wpuszczamy na imprezę. Albo wyłączasz, albo żegnam”. Działanie UBO możesz łatwo wstrzymać dla wybranych stron. Z czasem zaczniesz preferować serwisy, które nie czepiają się twojej konfiguracji przeglądarki.

Krok 4 – zmień przeglądarkę

Na początek wystarczy Firefox. Naprawdę.

Ciemna strona – Manifest v3. Jak Google zabija blokowanie reklam

Poza działaniem w interesie użytkowników, Firefox ma jedną wielką zaletę – jest to jedyna przeglądarka, której wersja mobilna obsługuje wtyczki! Od niedawna wszystkie desktopowe wtyczki można zainstalować na mobilce i dzięki temu lepiej kontrolować strony otwierane na smartfonie.

I tutaj ponownie kilka stron może kręcić nosem, na szczęście obecnie zdarza się to coraz rzadziej.

Ciekawostka

Czy wiecie skąd strony wiedzą z jakiej przeglądarki korzystacie? Przeglądarki wysyłają im swoją „wizytówkę” – user agent.

User-agent: Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:47.0) Gecko/20100101 Firefox/47.0

Jeśli przekonacie ją, aby przedstawiała się jako Chrome, te same strony, które twierdziły, że nie działają w tej przeglądarce, nagle zaczynają działać bez szwanku. Dziwne, prawda?

Możecie chcieć przenieść swoje zakładki i hasła. Firefox umożliwia taki import z innych przeglądarek. Zanim zdecydujecie się usunąć Chroma, powinniście ponownie się zalogować do wszystkich stron, oczywiście jeśli nie chcecie utracić dostępu do ważnych kont. Nic, rzecz jasna, nie stoi na przeszkodzie, aby trzymać je obie zainstalowane.

Krok 5 – przełącz się na alternatywnego klienta YouTube

Są 2 rodzaje oprogramowania sieciowego: serwerowe – zapewniające jakąś usługę, oraz klienckie – pozwalające się z nią połączyć. Np. przeglądarka www jest klientem, ale gdyby nie oprogramowanie na serwerze, mielibyśmy tylko interfejs, bez stron do przeglądania.

W alternatywnym internecie ten rozdział jest bardzo silny, tymczasem w mainstreamowym – strony i aplikacje, przeglądarki i wyszukiwarki, wraz z firmami za nimi stojącymi, noszą jedną i tę samą nazwę. To powoduje liczne nieporozumienia, a prostowanie tego nie jest w interesie korporacji. Wolą, byśmy nie rozumieli, że klient jest niezależnym tworem i może zostać zastąpiony klientem pozbawionym ograniczeń producenta, a nawet z wartością dodaną.

NewPipe to nieoficjalny klient YouTube na system Android:

- Nie ma żadnych reklam

- Subskrybowanie kanałów i podział na kategorie

- Dodawanie playlist do biblioteki i tworzenie własnych

- Odtwarzanie w tle lub w trybie Picture-In-Picture

- Pobieranie materiałów w wybranej jakości – wideo lub sam dźwięk – nawet napisy

- Dostosowanie prędkości odtwarzania, wycinanie ciszy

- Automatyczna kolejka

- Transmisje na żywo

- Jest lekki i szybki

- Wspiera także platformy: SoundCloud, Bandcamp, media.ccc i PeerTube

Istnieje wersja tej aplikacji z tzw. SponsorBlockiem, czyli autopomijaniem sponsorowanych fragmentów filmu.

Minusy:

- Brak logowania – subskrypcje i playlisty zostają na urządzeniu

Okazjonalne błędy wynikające ze zmian na stronie YouTube, naprawiane w kolejnej wersji

InnerTune, jest to aplikacja do odkrywania i słuchania muzyki, podobna do Spotify, też de facto klient YouTube (Music). Zresztą niejedyny.

Ładny interfejs

Spersonalizowane sugestie

Ulubione utwory, albumy i wykonawcy

Tworzenie własnych playlist

Logowanie do konta Google.

Teksty piosenek.

Niektóre strony (tzw. proxy) pełnią rolę pośrednika, anonimizując przeglądanie, a przy okazji poprawiając czytelność i pozbywając się niepożądanych cech.

Często korzystanie z takich rozwiązań to łamanie regulaminu. Niedawno YouTube wypowiedział wojnę Invidious i zaczął blokować adresy IP znanych serwerów (należy zauważyć, iż nie jest to pojedyncza strona, a cała masa identycznych stron – serwerów z zainstalowanym oprogramowaniem Invidious). Blokada sprawia, że proxy przestaje działać dla wszystkich. Mimo przeciwności, Invidious wymyśla nowe sposoby na ominięcie blokady, co się chwali.

Oliwier Jaszczyszyn – YouTube odjaniepawla. Co z tym robimy? (Prawie) nic.

Czy ów wyścig zbrojeń będzie trwał wiecznie? Czy któraś ze stron w końcu odpuści? Większość serwerów Bibliogram, Nitter i Libreddit/Teddit – proxy do Instagrama, Twittera i Reddita – już padła. Nie wytrzymali oporu.

Proxy i alternatywne klienty to tylko powierzchowne rozwiązania. Leczenie objawowe. Tak czy inaczej nadal korzystamy z korpo-platform i powinniśmy mieć świadomość, że pewnego dnia nasze ulubione obejście może zostać zamknięte i wtedy zostaniemy postawieni przed ultimatum. Dlatego nasza wędrówka nie powinna się na tym zakończyć. Teraz będzie już tylko łatwiej.

Co zatem powinieneś zrobić? Zainstaluj NewPipe lub InnerTune, korzystaj z Invidious i ciesz się, póki działają. Z wtyczką Libredirect możesz ustawić automatyczne przekierowanie. Oto dwa z działających w chwili pisania serwerów:

Krok 6 – odkryj Nextcloud

Gdy byłem młodszy, byłem wielkim fanem Googla. Nie wyszukiwarki oczywiście, lecz firmy i jej produktów. Wiecie – dysku, map, tłumacza, kalendarza, etc., dostęp do wszystkich usług z jednego konta. Inne duże firmy też tworzą takie środowiska. W przyszłości chciałem nawet pracować w Google.

Czasy się zmieniły, dorosłem i dziś mam innego faworyta – jest nim Nextcloud oraz znacznie szersze uniwersum FOSS. To ekosystem zdolny zastąpić inny ekosystem przy odrobinie chęci. Poszczególne pod-usługi (tzw. “aplikacje”) instaluje administrator serwera.

- Przechowywanie plików z zarządzaniem z poziomu przeglądarki, aplikacji lub menedżera plików

- Przeglądarkę zdjęć

- Kalendarz i kontakty

- Notatki

- Zakładki

- Ankiety/formularze

W internecie znajdziemy różnych dostawców Nextcloud różniących się zestawem aplikacji, przestrzenią dyskową czy regulaminem. Jeśli posiadamy własny serwer, też możemy zainstalować na nim Nextcloud – ja tak robiłem w ramach eksperymentu.

Pliki i foldery możemy udostępniać generując link i dostosowując uprawnienia, oraz ustawiając hasło dostępu – idealnie nadaje się do dzielenia się materiałami na studiach. Podobnie można udostępniać kalendarze i przykładowo stworzyć terminarz egzaminów, który można zasubskrybować w telefonie przez ICS.

Mała ciekawostka: obrazki na tym blogu są hostowane w Nextcloud.

Mała ciekawostka: obrazki na tym blogu są hostowane w Nextcloud.

Nextcloud umożliwia zdalny dostęp do danych przez WebDAV. Jeśli odpowiednio skonfigurujesz menedżer plików, możesz wygodnie kopiować pliki na chmurę bez odpalania przeglądarki. W ten sam sposób ogarniemy synchronizację swoich kontaktów, kalendarza i zakładek, aby ich nigdy nie zgubić. A w aplikacji mobilnej ustawimy automatyczny upload zdjęć z telefonu.

Nextclouda możesz wykorzystać do stworzenia ankiety. Co ważne, odpowiedzi wypełniających pozostaną poza zasięgiem Google czy Microsoftu – tylko ty i administrator serwera będą mieli dostęp.

Podsumowując: to jedno z najlepszych miejsc, gdzie może trafić ktoś opuszczający ekosystem Google. Polecam polski nch.pl (Nasza Chmura), utrzymywany przez FTdL (Fundacja Technologie dla Ludzi). Oferuje na start 15 GB za darmo. Jest to organizacja non-profit, ta sama co od pol.social. Jeśli uważasz, że robi dobrą robotę, rozważ jej wsparcie. Swojego Nextclouda mają także m.in. Disroot czy Hostux. Oprócz tego oferują inne alternatywne usługi, o których jeszcze napiszę.

Krok 7 – Pokaż innym, czego się nauczyłeś

Nie mamy reklamy, jeśli więc metody alternatywnego internetu mają trafić pod strzechy, sami musimy je reklamować tam, gdzie jesteśmy, czy to w przestrzeni cyfrowej, czy w świecie realnym. Bądźmy w tym szczerzy i naturalni, absolutnie nie chodzi bowiem o podbijanie statystyk, zdobywanie rynku czy zadowalanie inwestorów. W mojej liście celów znajdują się:

- Wskazanie rozwiązania problemu,

- Poszerzanie kompetencji cyfrowych u innych,

- Promowanie zdrowego stylu życia.

Nie jest to więc krok zupełnie przeciwstawny do kroku 1.

Wykorzystuj okazje:

- Reklama przerwała muzykę na imprezie? → Wspomnij o NewPipe/InnerTune (Android) lub Invidious/uBlock Origin (web).

- Udostępniasz katalog z plikami? → Wrzuć je na Nextclouda.

- Zakładasz grupowy kalendarz? → Ponownie, Nextcloud.

- Planujecie termin spotkania? → Powiadom wszystkich mailem.

- Spotykacie się online? → Zaproponuj Jitsi. Oszczędzicie sobie logowania i limitów czasu.

Po co mailem?

Dla zachowania porządku. Ważne ogłoszenia mogą zgubić się pośród luźnych rozmów. Poza tym, dajmy szansę tym, którzy nie mogą lub nie chcą korzystać z korporacyjnego komunikatora. Dla wygody polecam Delta Chat. Możecie nawet przenieść tam całą swoją konwersację, ale to wymaga współpracy uczestników.

Co to Jitsi?

Platforma do wideokonferencji. Można w niej bez logowania utworzyć spotkanie i udostępnić link uczestnikom. Zawiera m.in. wbudowany czat, ankiety i umożliwia udostępnianie zawartości ekranu. Moderator może zabezpieczyć dostęp do spotkania hasłem lub ręczną akceptacją.

Przykładowe serwery:

– calls.disroot.org

– jitsi.tildeverse.org

– meet.techsaviours.org

Niestety nie na wszystko będziemy mieć wpływ, nie zawsze też inni zaakceptują nasze rozwiązania. Może się zdarzyć tak, że pewne narzędzia będziemy mieli narzucone odgórnie, przez szkołę lub pracodawcę. Ale warto podejmować próby, nie wszystko przecież okaże się barierą nie do przejścia.

Napisanie kompletnej listy kroków do osiągnięcia wolności cyfrowej nie byłoby możliwe. To nieustanny rozwój, mnóstwo nowych możliwości i technologii, które warto poznawać i promować, zamiast zamykać się na kilka popularniejszych aplikacji.

Certyfikat można podejrzeć na komputerze, klikając 🔒 na pasku adresu.

Certyfikat można podejrzeć na komputerze, klikając 🔒 na pasku adresu. Schemat nie uwzględnia adresów IP. Są na innych etykietach.

Edit: na rysunku jest błąd. Numery paczek są w odwrotnej kolejności

Schemat nie uwzględnia adresów IP. Są na innych etykietach.

Edit: na rysunku jest błąd. Numery paczek są w odwrotnej kolejności

Mała ciekawostka: obrazki na tym blogu są hostowane w Nextcloud.

Mała ciekawostka: obrazki na tym blogu są hostowane w Nextcloud.

Na zdjęciu: jeden z wpisów w formacie ActivityPub, metoda odkryta dzięki

Na zdjęciu: jeden z wpisów w formacie ActivityPub, metoda odkryta dzięki